pandas

jstl

st-link

armv9

bert

HTML5期末考核大作业

文件

元开发

语言模型

流媒体

svn

如何修复网站漏洞

互联网

工作流程数字化

图片提取

codeblock

session_key

期末考试

MVCC

nvidia

Seq2Seq

2024/4/12 10:50:07NLP:训练一个中文问答模型Ⅰ-Step by Step

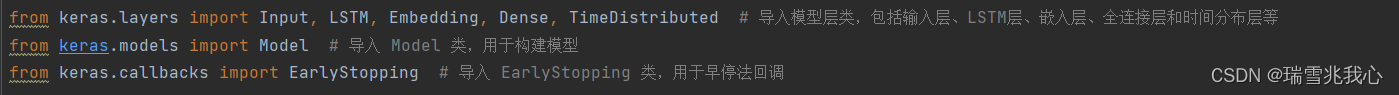

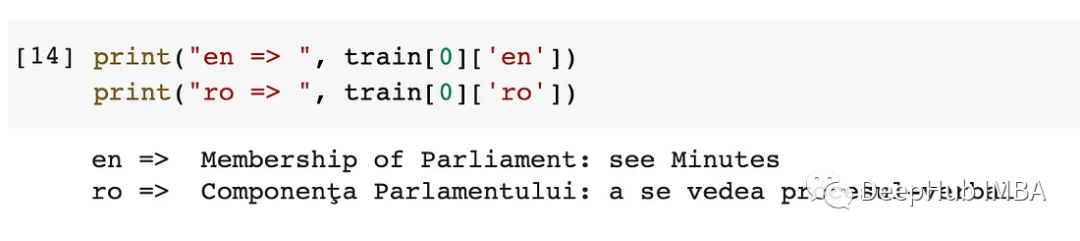

训练一个中文问答模型I-Step by Step 本文基于经典的NMT架构(Seq2SeqAttention),训练了一个中文问答模型,把问题到答案之间的映射看作是问题到答案的翻译。基于Tensorflow 2.x实现,分词采用了jieba,在中文词汇粒度上训…

使用 Seq2Seq 模型进行文本摘要

目录

引言

1 导入数据集

2 清洗数据集

3 确定允许的最大序列长度

4 选择合理的文本和摘要

5 对文本进行标记

6 删除空文本和摘要

7 构建模型

7.1 编码器

7.2 解码器

8 训练模型

9 测试模型

10 注意

11 整体代码 引言

文本摘要是指在捕捉其本质的同时缩短长文本的…

tensorflow之seq2seq阅读笔记

学习tensorflow最好的方式还是阅读官方文档:https://www.tensorflow.org/versions/r0.12/tutorials/seq2seq/

一、tensorflow的RNN使用:

1.使用LSTM lstm rnn_cell.BasicLSTMCell(lstm_size)# Initial state of the LSTM memory.state tf.zeros([bat…

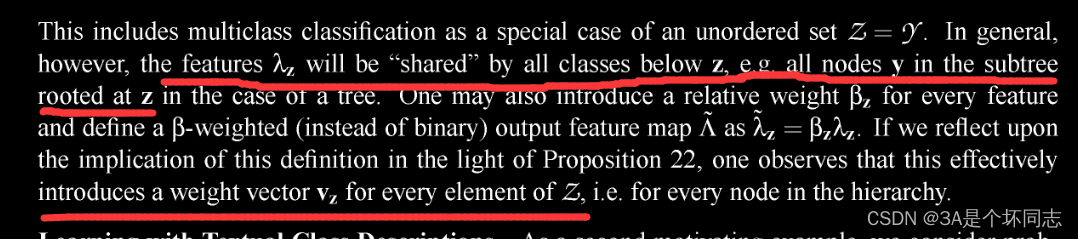

针对结构映射的SVM算法:核心思路解读

最近准备做一个NER和指代消解相关的课题,在和同学们读相关文章。今天有个同学找到了个挺有意思的文章,用SVM做NER的。我感觉这想法挺奇特的,SVM怎么处理文本和序列?于是我去看了一下,他找的那篇文章是个套壳文章&#…

自动文摘(Automatic document summarization)方法综述(四)——基于神经网络的(neural summarization)方法

前三篇博客(一)、(二)、(三)总结了抽取式自动文摘的一些经典方法,传统抽取式自动文摘方法将文档简单地看作是一组文本单元(短语、句子等)的集合,忽略了文档所…

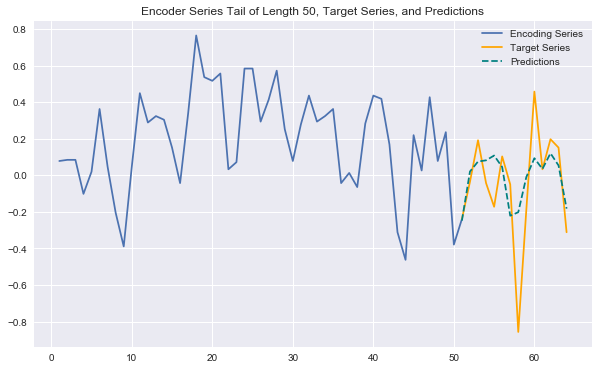

基于卷积的神经网络的时间序列预测——WaveNet

基于卷积的神经网络的时间序列预测——WaveNet

原文博客的参考地址:https://jeddy92.github.io/JEddy92.github.io/ts_seq2seq_conv/

项目参考地址:https://github.com/JEddy92/TimeSeries_Seq2Seq/blob/master/notebooks/TS_Seq2Seq_Conv_Intro.ipynb…

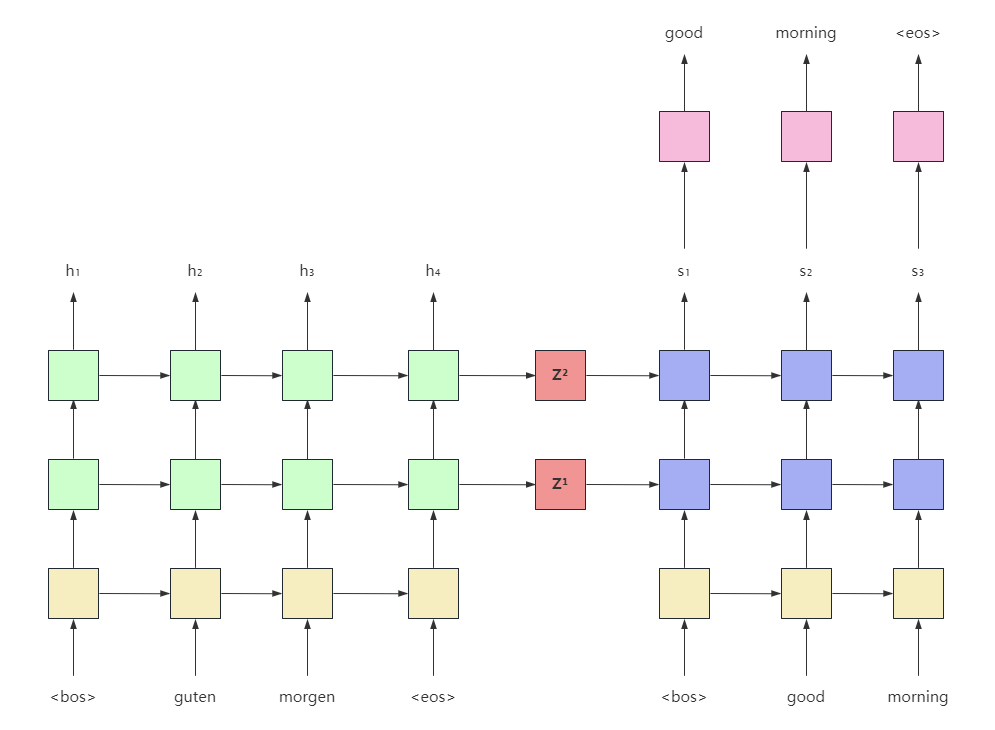

从零实现深度学习框架——Seq2Seq机器翻译实战

引言 本着“凡我不能创造的,我就不能理解”的思想,本系列文章会基于纯Python以及NumPy从零创建自己的深度学习框架,该框架类似PyTorch能实现自动求导。 💡系列文章完整目录: 👉点此👈 要深入理解…

Huggingface微调BART的代码示例:WMT16数据集训练新的标记进行翻译

BART模型是用来预训练seq-to-seq模型的降噪自动编码器(autoencoder)。它是一个序列到序列的模型,具有对损坏文本的双向编码器和一个从左到右的自回归解码器,所以它可以完美的执行翻译任务。 如果你想在翻译任务上测试一个新的体系…

seq2seq与引入注意力机制的seq2seq

1、什么是 seq2seq?

就是字面意思,“句子 到 句子”。比如翻译。

2、seq2seq 有一些特点

seq2seq 的整体架构是 “编码器-解码器”。

其中,编码器是 RNN,并将 最后一个hidden state(隐藏状态)【即&…

基于Seq2Seq模型的机器翻译

如标题所见,这篇博客的主题就是基于Seq2Seq模型的机器翻译,它的主要任务就是将一种语言翻译为另一种语言,在这里我们以英语翻译成法语为例子,如Im a student.---->>>Je suis tudiant.

这份数据是公开,可以直…

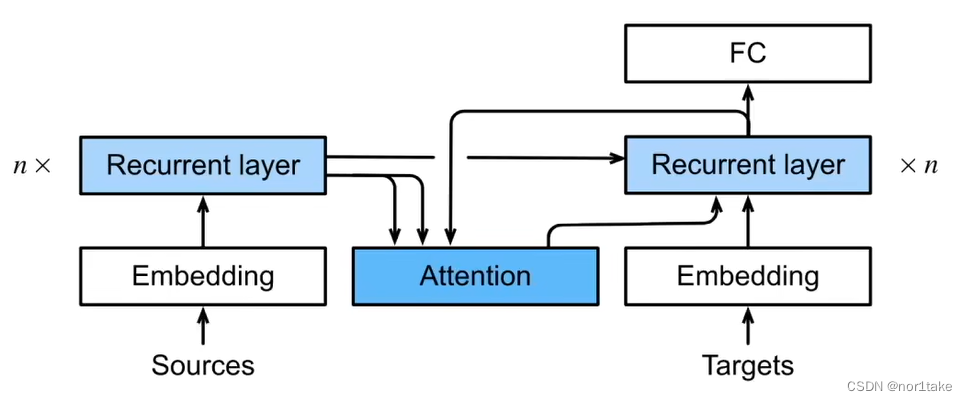

引入Attention的Seq2Seq模型-机器翻译

在上一篇博客中,我们介绍了 基于Seq2Seq模型的机器翻译。今天,在此基础上,对模型加入注意力机制Attention。

模型结构

首先,我们先了解一下模型的结构,基本与Seq2Seq模型大体一致:

首先,第一…

NLP中的Seq2Seq与attention注意力机制

文章目录 RNN循环神经网络seq2seq模型Attention(注意力机制)总结参考文献RNN循环神经网络

RNN循环神经网络被广泛应用于自然语言处理中,对于处理序列数据有很好的效果,常见的序列数据有文本、语音等,至于为什么要用到循环神经网络而不是传统的神经网络,我们在这里举一个…

NLP学习笔记(五) 注意力机制

大家好,我是半虹,这篇文章来讲注意力机制 (Attention Mechanism) 在序列到序列模型中的应用 在上一篇文章中,我们介绍了序列到序列模型,其工作流程可以概括为以下两个步骤

首先,用编码器将输入序列编码成上下文向量&a…